GOTNet

Huiyuan Chen, Chin-Chia Michael Yeh, Fei Wang, and Hao Yang. 2022. Graph Neural Transport Networks with Non-local Attentions for Recommender Systems.

概述

存在问题

- GNNs获取长距离的协同信号主要基于网络的深度,过深的网络会带来以下问题

- 过拟合现象(over-fitting)

- 堆叠过多的GNN层--->节点具有高度重叠的接收域--->节点的嵌入变得十分相似(over-smoothing)

目标

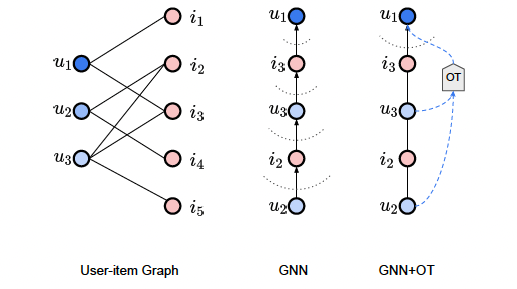

Figure1 : An illustration of local and non-local operators for collecting long-range messages

Figure1 : An illustration of local and non-local operators for collecting long-range messages

通过融合GCN和K-means在不加深GNN网络模型深度的前提下同时收集局部信息以及非局部信息。

解决方案

- 提出GOTNet模型避免通过加大网络的深度获取高阶的协同信号

- k-means

- 针对于GNNs的每一个Layer都进行一个聚类操作,在每一层都声称k个簇(也就是k个质心)

- 然后在每一层针对于k个质心进行Multi-head self-attention操作

- 融合

- 融合经过k-means步骤的非局部性Embedding与传统GNN的局部性Embedding用于后续的操作。

方案

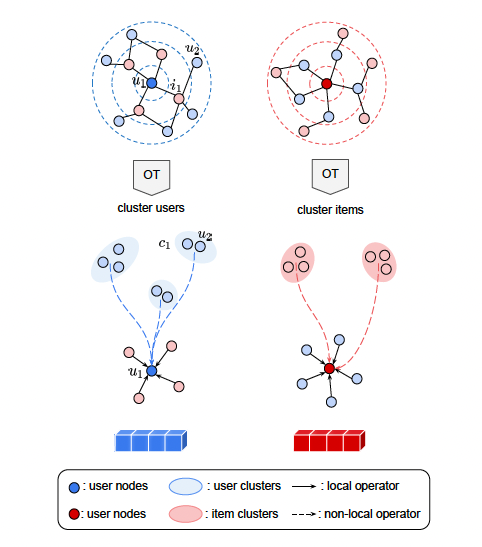

Figure2 :An overview of GOTNet, where a target user/item node will aggregate both local messages (e.g., neighbors) and non-local messages (e.g., user/item centroids).

Figure2 :An overview of GOTNet, where a target user/item node will aggregate both local messages (e.g., neighbors) and non-local messages (e.g., user/item centroids).

K-means Clustering with GNNs

动机(具有相同兴趣的用户很有可能购买相似的商品)--> 方案(针对于GNNs不同层的用户/商品进行聚类)

定义:

表示

之后针对于K-means算法不可微的特点,论文讲述了如何将k-means转换成为一个可微(也就是可以供后向传播)的形式。

Attention Mixing

Single Head Non-local Attention

其中

Multi-head Non-local Attentions

类似于多头注意力机制,假设有H个head,则最终的Multi-head Noe-local Attentions可以表示为:

Mixing Local and Non-local Attentions

其中

Optimization with GOTNet