MMoE

Ma, Jiaqi, et al. "Modeling task relationships in multi-task learning with multi-gate mixture-of-experts." Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. 2018. ## 概述

问题

多任务学习框架中,多任务学习模型对与不同任务之间的相关性很敏感,导致相关性高/低的学习任务不能够很好的建模。

解决方案

- 通过门控机制控制不同专家网络对不同任务的贡献程度

策略

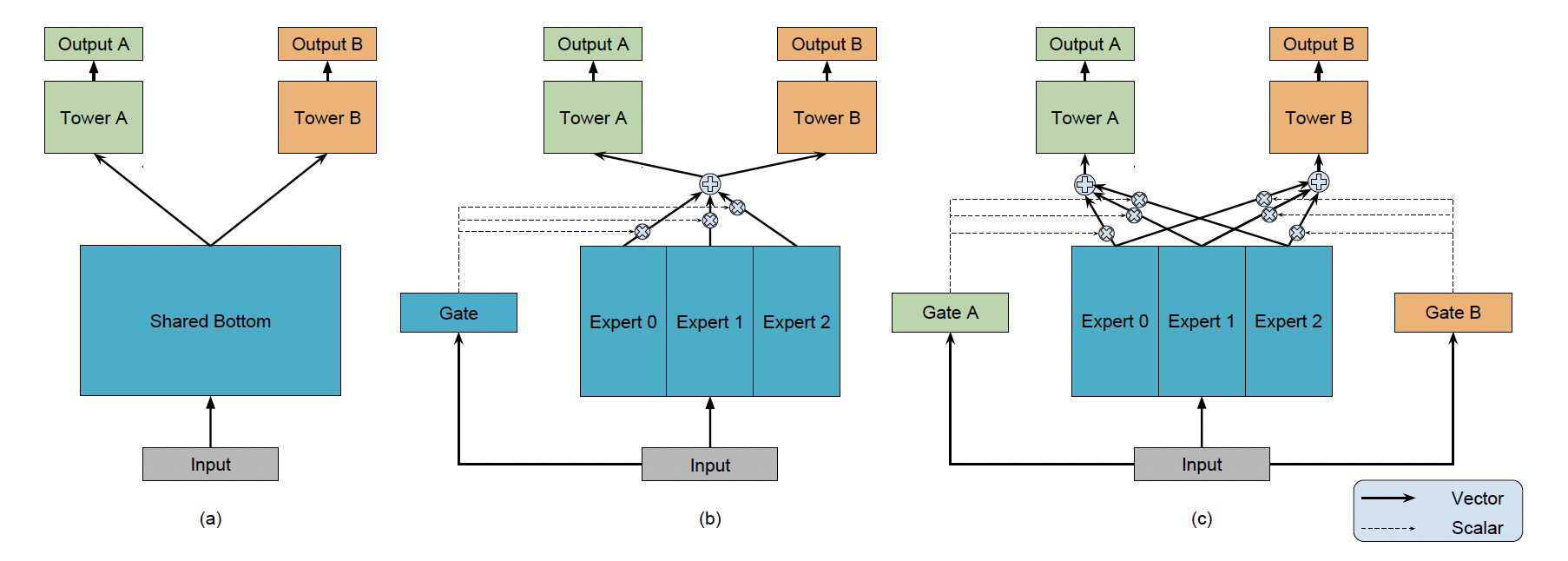

> Shared Bottom 模型(a)

> Shared Bottom 模型(a)

其模型可以抽象建模成为:

其中,

MoE(Mixture-of-Experts)(b)

其模型可以抽象建模成为:

其中,

缺陷:(没有区分不同专家网络对不同任务之间的重要性程度)

MMoE(Multi-gate Mixture-of-Experts)(c)

为了解决MoE的缺陷,MMoE针对于每一个任务增加了一个门控网络

其模型可以抽象建模成为:

其中,

特征抽取网络:

门控网络:

其中,

预期目标

相关性较低的任务 --> 一些共享的专家网络将会被惩罚,并且门控网络会去学习如何利用这些共享的专家网络。

Example

假设一个MMoE网络有两个Task,3个Expert Network,输入为

则针对于第一个任务,我们可以抽象建模成为: